Task 02 回归

2 Task02开始啦!

参照开源文档,观看视频 P3-4:机器学习介绍(2天),视频地址:https://www.bilibili.com/video/av59538266

回归 (Regression)

- 模型假设:选择模型框架(线性模型)

- 模型评估:如何判断众多模型的好坏?(损失函数(Loss Function))

- 模型优化:如何筛选出最优的模型?(GD(梯度下降))

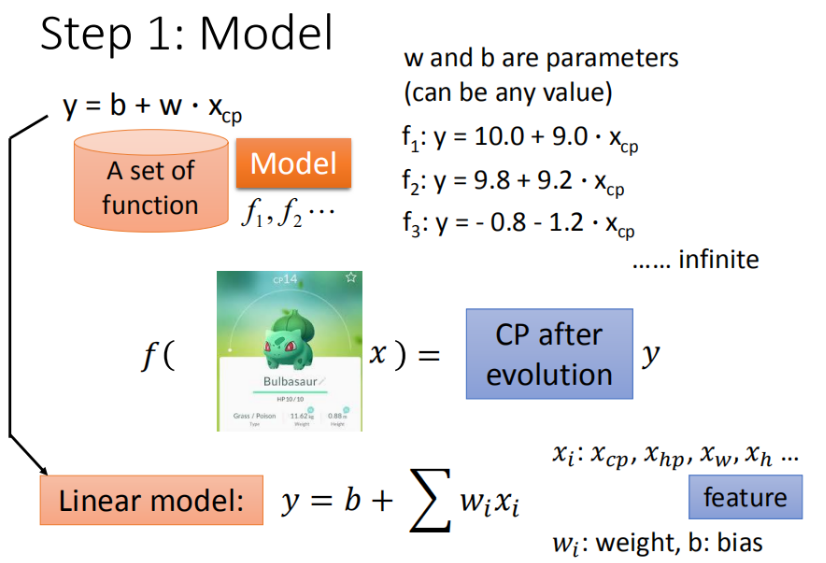

Step 1: 模型假设:线性模型

- 假设线性模型(Linear model):

$$ y = b + \sum w_ix_i $$

- $x_i$:就是各种特征(fetrure) $x_{cp},x_{hp},x_w,x_h,···$

- $w_i$:各个特征的权重 $w_{cp},w_{hp},w_w,w_h,··$

- $b$:偏移量

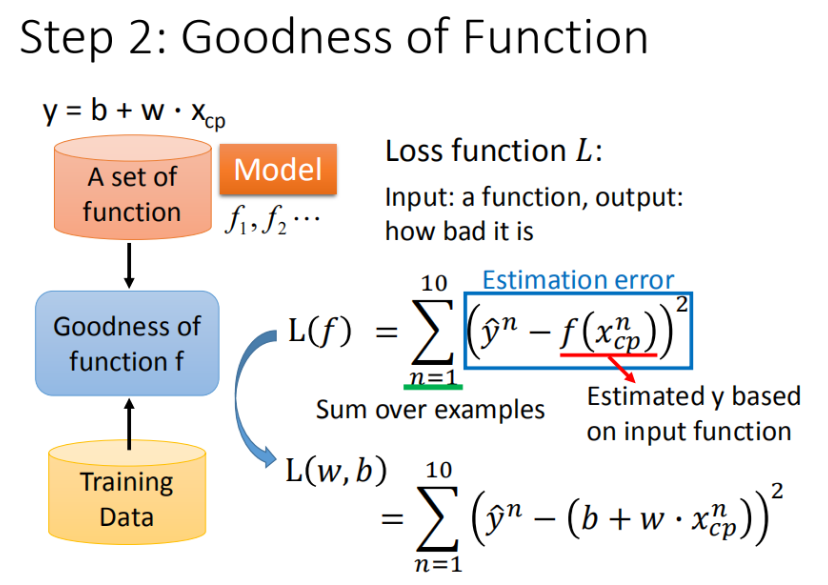

Step 2: 模型评估:损失函数(loss function)

2.1 收集和查看训练数据

将10组原始数据在二维图中展示,图中的每一个点 $(x_{cp}^n,\hat{y}^n)$ 对应着 进化前的CP值 和 进化后的CP值。

2.2 如何判断众多模型的好坏

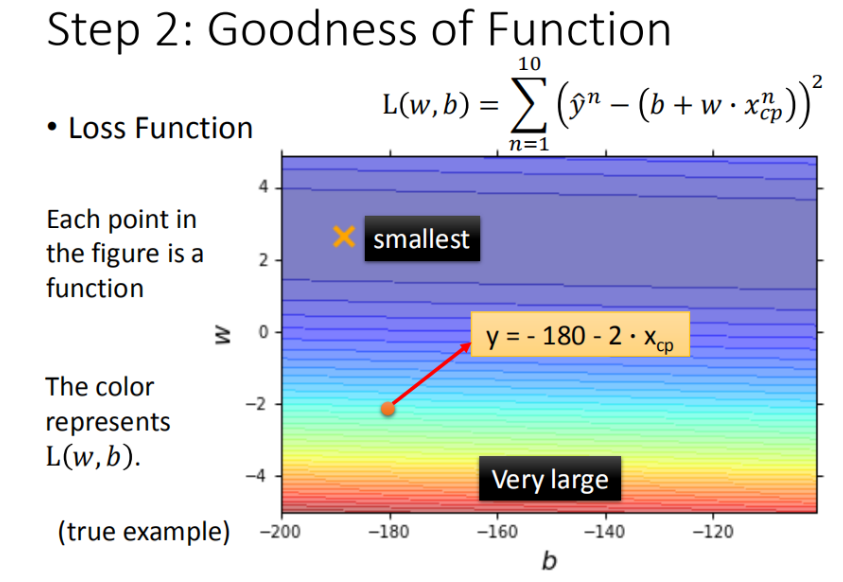

求【进化后的CP值】与【模型预测的CP值】差,来判定模型的好坏。也就是使用损失函数(Loss function) 来衡量模型的好坏,统计10组原始数据 $\left ( \hat{y}^n - f(x_{cp}^n) \right )^2$ 的和,和越小模型越好。如下图所示:

我们将 $w$, $b$ 在二维坐标图中展示,如图所示:

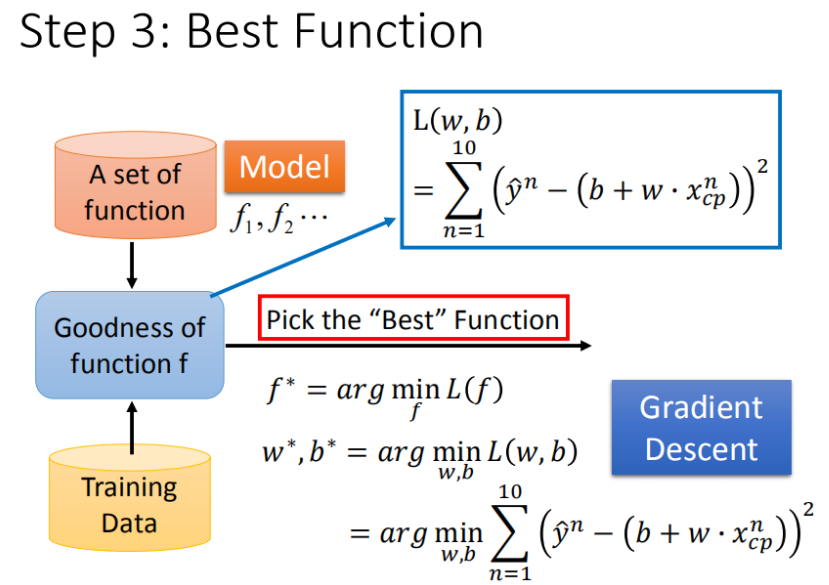

Step 3: 最优模型:梯度下降

3.1 如何筛选最优的模型(参数w,b)

已知损失函数是 $L(w,b)= \sum_{n=1}^{10}\left ( \hat{y}^n - (b + w·x_{cp}) \right )^2$ ,需要找到一个令结果最小的 $f^*$,在实际的场景中,我们遇到的参数肯定不止 $w$, $b$。

先从最简单的只有一个参数$w$入手,定义$w^* = arg\ \underset{x}{\operatorname{\min}} L(w)$

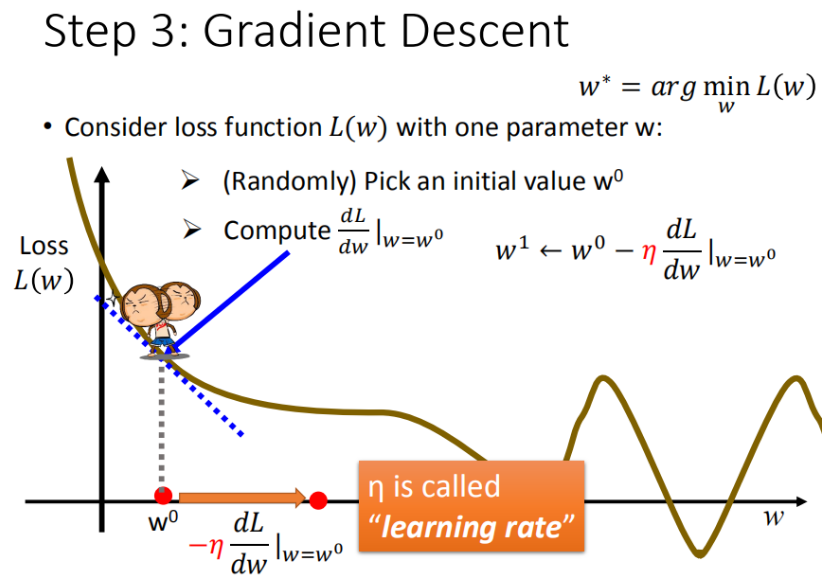

首先在这里引入一个概念 学习率 :移动的步长,如图7中 $\eta$

- 步骤1:随机选取一个 $w^0$

步骤2:计算微分,也就是当前的斜率,根据斜率来判定移动的方向

- 大于0向右移动(增加$w$)

- 小于0向左移动(减少$w$)

- 步骤3:根据学习率移动

- 重复步骤2和步骤3,直到找到最低点

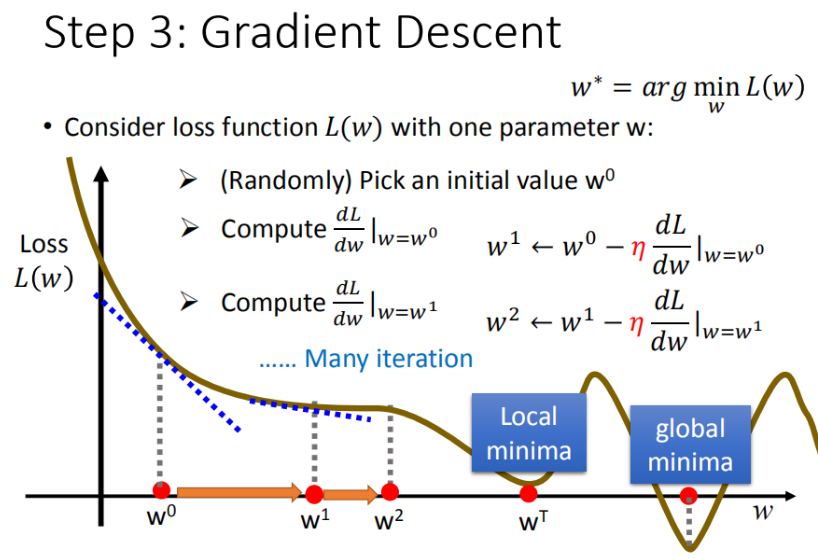

步骤1中,我们随机选取一个 $w^0$,如图8所示,我们有可能会找到当前的最小值,并不是全局的最小值,这里我们保留这个疑问,后面解决。

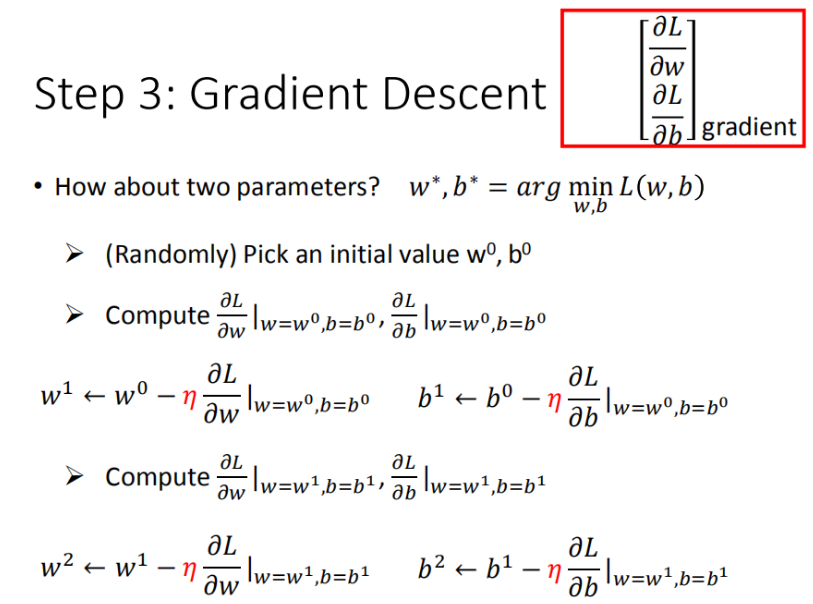

解释完单个模型参数$w$,引入2个模型参数 $w$ 和 $b$ , 其实过程是类似的,需要做的是偏微分

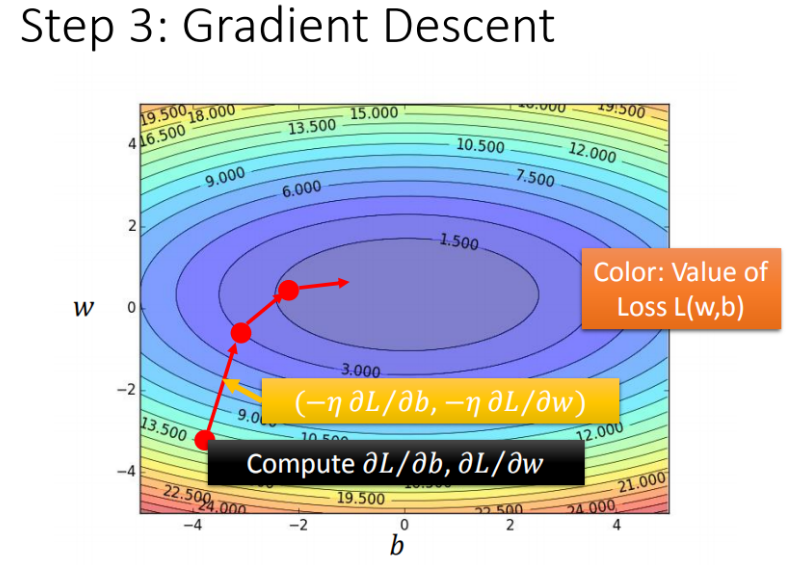

3.2 梯度下降推演最优模型的过程

3.3 梯度下降算法在现实世界中面临的挑战

我们通过梯度下降gradient descent不断更新损失函数的结果,这个结果会越来越小,那这种方法找到的结果是否都是正确的呢?前面提到的当前最优问题外,还有没有其他存在的问题呢?

其实还会有其他的问题:

- 问题1:当前最优(Stuck at local minima)

- 问题2:等于0(Stuck at saddle point)

- 问题3:趋近于0(Very slow at the plateau)

注意:其实在线性模型里面都是一个碗的形状(山谷形状),梯度下降基本上都能找到最优点,但是再其他更复杂的模型里面,就会遇到 问题2 和 问题3 了

3.4 w和b偏微分的计算

4 如何验证训练好的模型的好坏?

使用训练集和测试集的平均误差来验证模型的好坏.

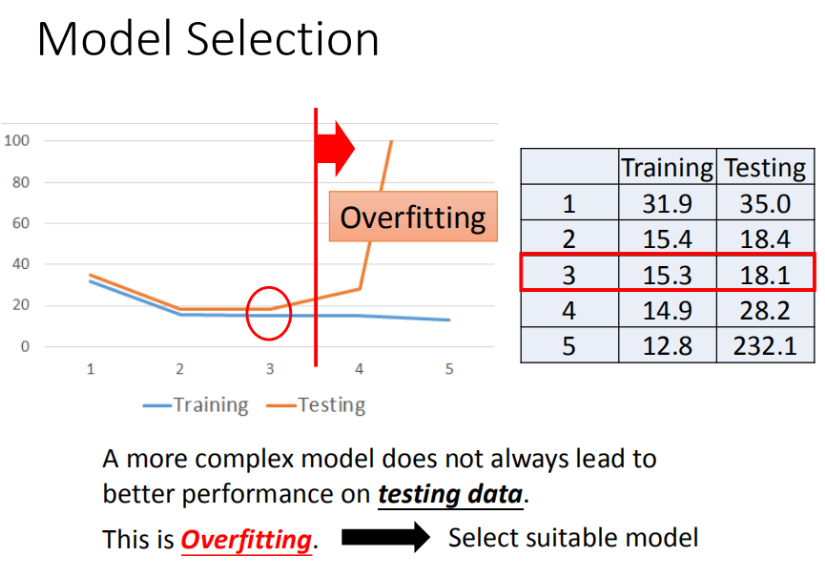

4.1 过拟合

在训练集上面表现更为优秀的模型,为什么在测试集上效果反而变差了?这就是模型在训练集上过拟合的问题。

5 模型步骤优化

输入更多样本数据,相同的起始CP值,但进化后的CP差距竟然是2倍。其实将Pokemons种类通过颜色区分,就会发现Pokemons种类是隐藏得比较深得特征,不同Pokemons种类影响了进化后的CP值的结果。

5.1 Step1优化:2个input的四个线性模型是合并到一个线性模型中

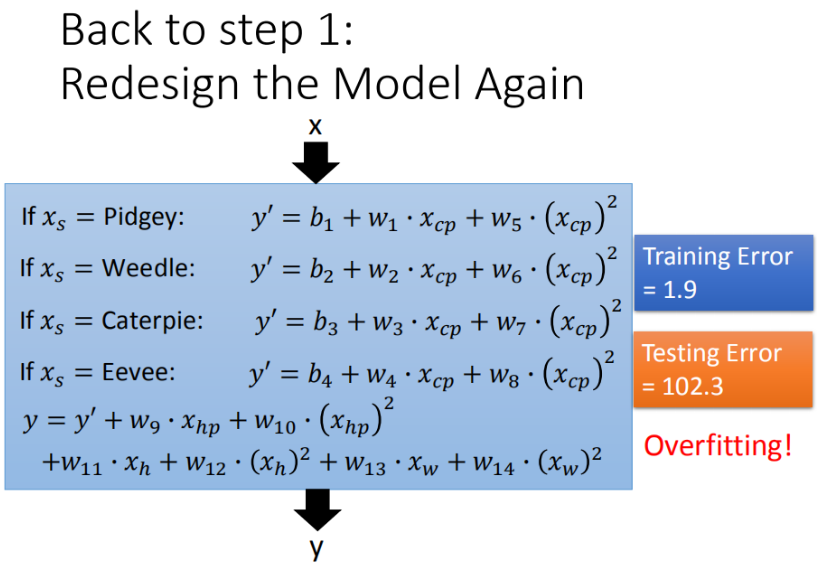

5.2 Step2优化:如果希望模型更强大表现更好(更多参数,更多input)

在最开始我们有很多特征,图形化分析特征,将血量(HP)、重量(Weight)、高度(Height)也加入到模型中

更多特征,更多input,数据量没有明显增加,仍旧导致overfitting

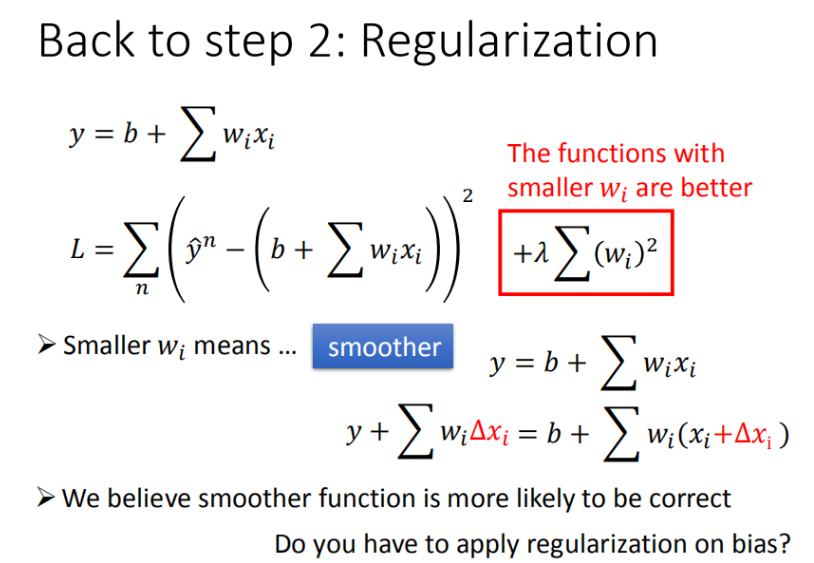

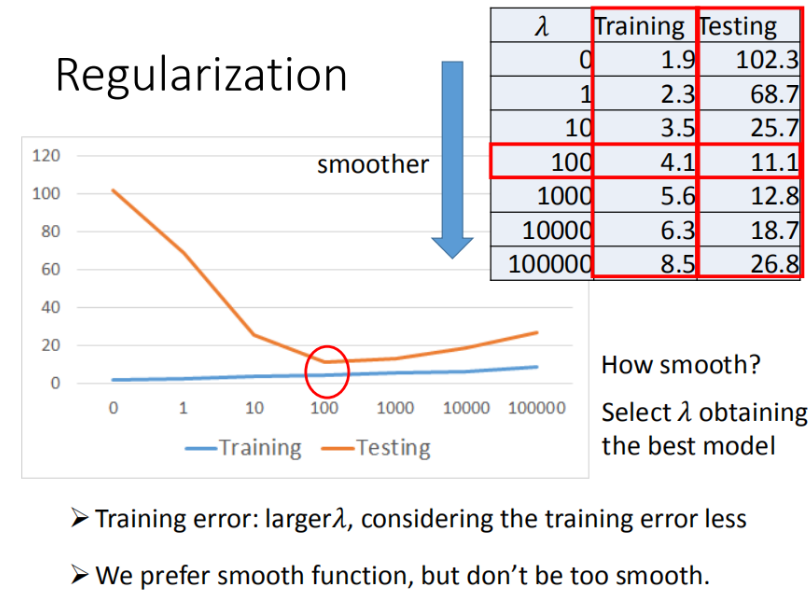

5.3 Step3优化:加入正则化

- $w$ 越小,表示 $function$ 较平滑的, $function$输出值与输入值相差不大

- 在很多应用场景中,并不是 $w$ 越小模型越平滑越好,但是经验值告诉我们 $w$ 越小大部分情况下都是好的。

- $b$ 的值接近于0 ,对曲线平滑是没有影响

本作品采用 知识共享署名-相同方式共享 4.0 国际许可协议 进行许可。

评论已关闭